简单体验一下本地部署DeepSeek

最近DeepSeek很火呀,正好手头有显卡,当时为了打游戏买的,结果买来后就没玩过啥游戏了… 正好借这个机会让他运行着锻炼一下,否则平常风扇都不带转的我怕它都要生锈了。

下载ollama,Windows直接下载exe安装就行

https://ollama.com/download

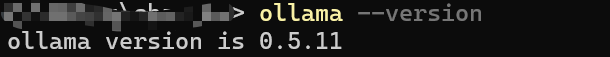

验证安装

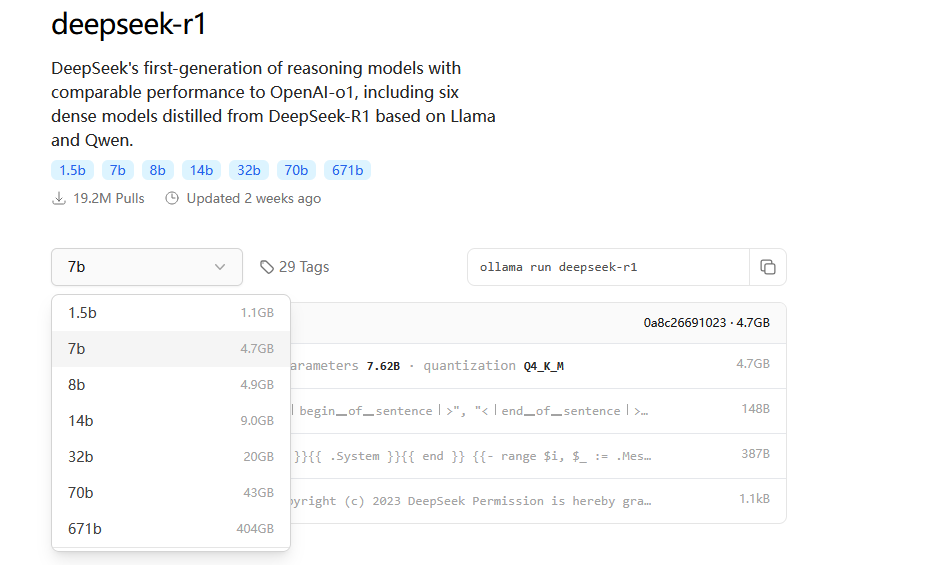

这是DeepSeek R1的模型地址https://ollama.com/library/deepseek-r1,可以在里面看到发布的各版本模型

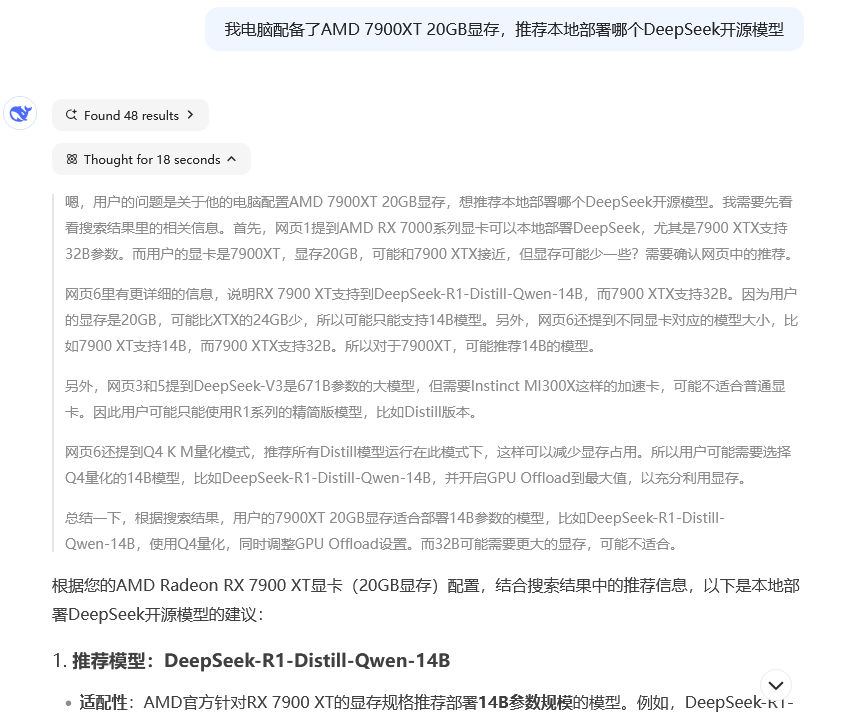

想知道直接的显卡适合哪个模型,可以直接问DeepSeek,主打一个原汤化原食

那么就用这个模型吧

1 | ollama run deepseek-r1:14b |

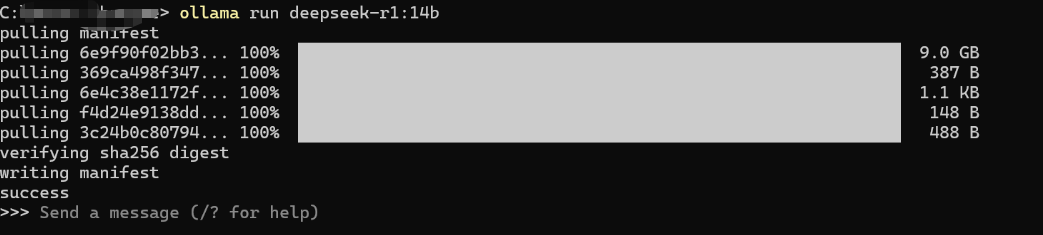

因为本地没有这个模型,所以跑上面的命令后会先把模型下载下来

等了半天,终于下好了

下好之后会立刻问你要不要发送个聊天,那赶紧体验一下叭

首先问候一下

嗯。。。好像有点慢,上面这个结果将近1分钟才生成

GPU也基本上跑满了

再问一下,这次好像稍微快了点。掐着秒表计时了一下,用了1分20秒生成了下面的内容。而且思考的内容还有上下文,非常不错

再来一道经典的弱智吧问题

对比一下在线的deepseek,感觉在线版的回答更全面点

不过总结的内容两者大差不差。就是本地部署的生成结果还是比在线版慢了不止一点,硬件上的差距还是太大了。可能部署7B或者8B的模型会好点吧